🚀 Une arrivée très attendue dans l’univers de l’IA

Meta a récemment dévoilé Llama 4, la nouvelle version de son modèle de langage open source. Présenté comme une avancée majeure capable de rivaliser avec GPT-4.5, Claude 3.7 et Gemini 2.0 Pro, ce modèle promet beaucoup. Mais qu’en est-il réellement ? Chez TrueHub AI, on l’a testé pour vous. Voici notre analyse.

🔍 Qu’est-ce que Llama 4 ?

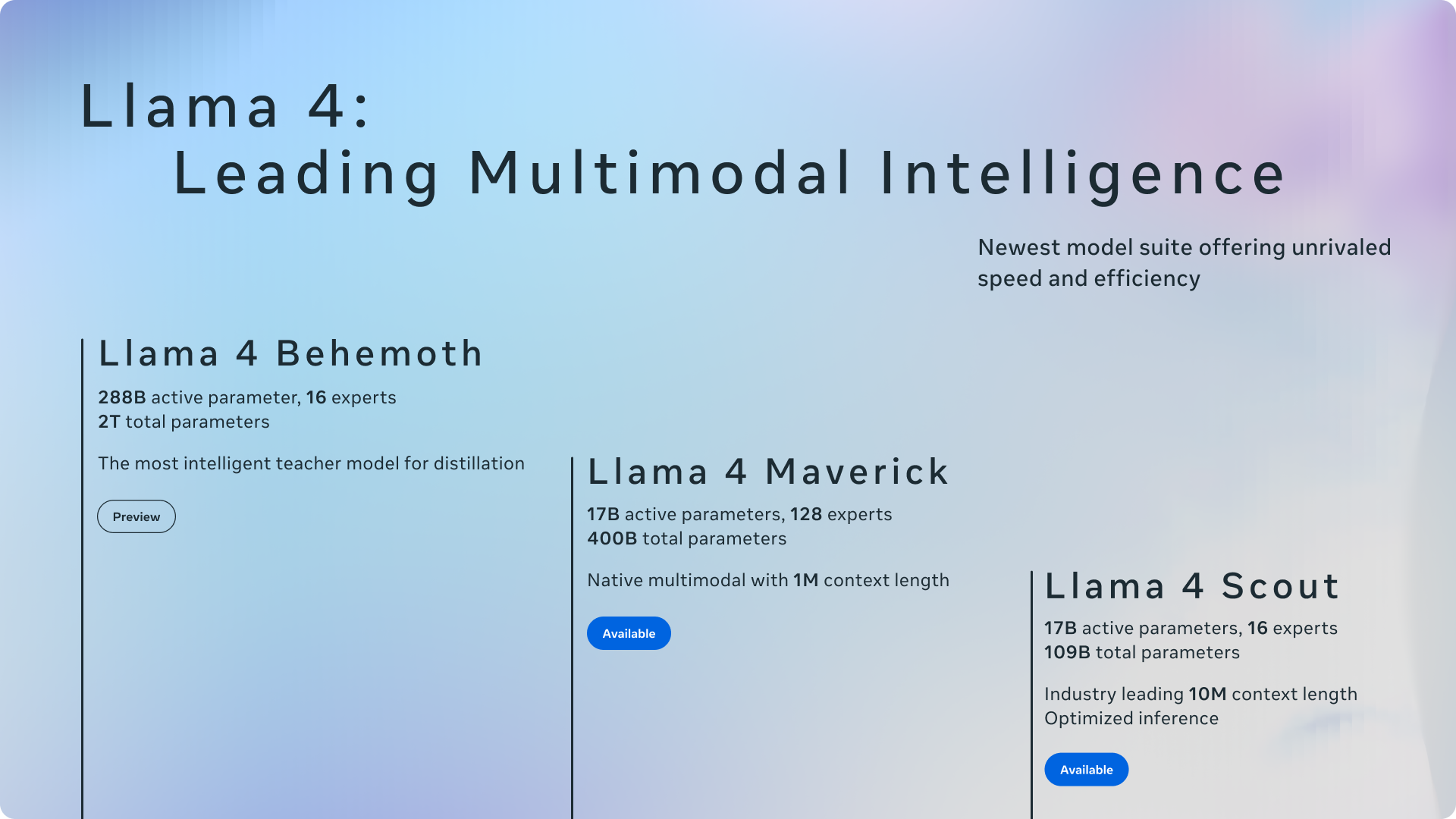

Llama 4 se décline en deux versions principales : Scout et Maverick. Tous deux utilisent 17 milliards de paramètres actifs par inférence, mais diffèrent dans l’architecture des experts utilisés (MoE) :

- Scout : 16 experts

- Maverick : 128 experts

Grâce à ce système, seule une fraction du modèle est activée à chaque tâche, ce qui réduit considérablement les ressources nécessaires. Exemple : Maverick dispose de 400 milliards de paramètres totaux, mais n’en active que 17 milliards à la fois — ce qui permet son exécution sur une seule carte NVIDIA H100.

🧠 Fonctionnalités avancées

Llama 4 se distingue par :

- 🔁 Fenêtre de contexte de 10 millions de tokens (contre 128K auparavant)

- 🖼️ Multimodalité native : texte, images, vidéos fusionnés dès l’entraînement

- 📚 Capacité à analyser de multiples documents, coder et résumer des ensembles complexes de données

⚖️ Les limites de Llama 4

Malgré un marketing impressionnant, plusieurs tests indépendants ont révélé des faiblesses :

- 🔍 Mauvais résultats sur les tests de raisonnement logique simples

- 🌐 Incohérences dans les réponses multilingues (ex : anglais vs espagnol)

- 📉 Échec sur des tâches longues malgré la promesse d’une fenêtre de 10M tokens

- 🛑 Filtrage excessif de contenu – même des demandes légitimes sont bloquées

À noter également que certains experts ont accusé Meta d’avoir optimisé ses modèles pour les évaluations humaines au détriment de la précision factuelle.

📖 Créativité & narration : un vrai point fort

Dans le domaine de la création littéraire, Llama 4 brille. Il génère des récits riches en détails sensoriels et culturels, avec une narration immersive. Par exemple, une histoire impliquant un anthropologue maya a révélé une profondeur rarement atteinte par d’autres modèles.

Comparé à GPT-4.5, Llama-4 propose un style plus organique, idéal pour les récits historiques ou philosophiques. Cela en fait une excellente base pour des fine-tunes dédiés à l’écriture créative.

🧩 Raisonnement non-mathématique

Llama 4 est performant sur les problèmes complexes nécessitant une analyse détaillée. Lors d’un test type « BIG-bench », le modèle a su identifier le bon coupable en déduisant logiquement les indices. Un bon point pour les applications de résolution de problèmes complexes.

🔐 Censure et sujets sensibles

Llama 4 applique une modération très stricte. Même des scénarios inoffensifs liés à la cybersécurité ou aux relations humaines sont refusés. Cela peut être frustrant, mais son statut open source permet aux développeurs de lever ces restrictions si nécessaire.

🧪 Tests de performance

En test réel :

- ✅ Bonne récupération d’information sur 85K tokens

- ❌ Échec total sur des contextes à 300K tokens (loin des 10M promis)

- ⚠️ Erreurs de compréhension en logique simple (ex : l’énigme du mari de la veuve)

💻 Matériel requis

La puissance nécessaire pour faire tourner Llama 4 localement reste un obstacle. La carte NVIDIA H100 coûte environ 490 000 $, et même la version allégée « Scout » demande une carte RTX A6000 (environ 5 000 $). Heureusement, des versions quantisées facilitent un déploiement sur GPU plus modestes.

🔚 Conclusion : Llama 4, un excellent point de départ

Llama 4 est une base open source prometteuse, notamment pour les créateurs de contenus, les chercheurs et les développeurs. Malgré des limites claires face à la promesse marketing, c’est une alternative crédible aux modèles propriétaires. La communauté aura sans doute un rôle clé à jouer dans l’amélioration et l’adaptation de ce modèle.

✅ Avantages : open source, créativité, raisonnement non-mathématique

❌ Inconvénients : logique limitée, modération stricte, performances inconstantes

En résumé, Llama 4 n’est peut-être pas le game-changer annoncé, mais c’est un modèle à suivre de très près en 2025.